日本伺服器延遲測試與優化方法

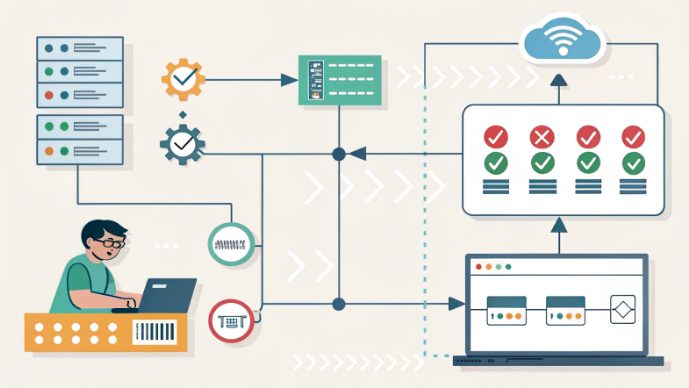

在全球數位基礎設施領域,日本伺服器憑藉其區位優勢、穩定的網路連接及合規性特點,在面向東亞市場的業務中表現突出。然而,即便是配置優良的伺服器,也可能受網路延遲影響,導致即時應用卡頓、資料傳輸效率下降及使用者體驗受損。本文針對技術人員,深入講解日本伺服器租用或伺服器託管場景下的技術診斷方法、可落地的優化方案及產業最佳實務。

理解網路延遲基礎

在探討解決方案前,需先從技術層面明確延遲的定義。本質上,網路延遲是指資料包在使用者端與伺服器之間往返的時間(RTT),這與衡量資料傳輸量的「吞吐量」概念不同。對於服務中國大陸使用者的日本伺服器,理想狀態下RTT通常在50ms至150ms之間,但受以下因素影響會出現波動:

- 物理距離及光纖中的信號傳播速度

- 國際交換節點(如香港、西雅圖互聯點)的網路壅塞情況

- 跨自治系統的路由器效率及路由表複雜度

- 伺服器硬體效能,包括基於Intel或AMD系統的CPU排程效率與記憶體延遲

對於線上遊戲、金融交易、高畫質視訊會議等對延遲敏感的應用,即使RTT僅增加20ms,也可能顯著影響效能。因此,首要任務是判斷延遲源於伺服器架構、網路路徑還是使用者端環境,這是系統化優化的第一步。

專業級延遲測試工具與方法

精準的故障診斷需要一套包含標準工具與進階工具的組合,以下是核心工具及使用指南:

核心診斷工具

- ICMP Ping:測量RTT的基礎工具。在Linux/macOS系統中,執行

ping -c 100 server_ip傳送100個資料包並計算平均延遲;Windows系統則執行ping -n 100 server_ip。需重點關注的指標:最小/最大/平均RTT及封包遺失率。 - Traceroute:追蹤使用者端與伺服器之間的網路路徑。Linux/macOS系統:

traceroute server_ip;Windows系統:tracert server_ip。需排查延遲超過100ms或存在封包遺失的節點,這些節點通常是網路瓶頸所在。 - MTR(My Traceroute):融合Ping與Traceroute功能的動態互動工具,可即時顯示每跳節點的延遲與封包遺失情況,適合尖峰時段的長期監控:

mtr --report-wide server_ip。 - Speedtest CLI:可跨全球伺服器節點測量上傳/下載吞吐量及延遲。透過

curl -s https://install.speedtest.net/app/cli/install.sh | sh安裝,執行speedtest --server 12345(將12345替換為日本伺服器節點ID)進行測試。

基於指令碼的自動化測試

對於大規模環境,Python指令碼可實現測試的可程式化。以下是使用pythonping函式庫測試多節點延遲的基礎範例:

import pythonping

from datetime import datetime

def test_latency(host, count=50):

results = pythonping.ping(host, count=count)

avg_latency = sum(r.time_elapsed_ms for r in results) / count

loss_rate = (count - len(results)) / count * 100

return {

"timestamp": datetime.now().isoformat(),

"host": host,

"average_latency_ms": avg_latency,

"packet_loss_percent": loss_rate

}

# 測試多個日本伺服器IP

servers = ["203.0.113.1", "198.51.100.1"]

for server in servers:

print(test_latency(server))標準化測試流程

為確保測試資料可靠,需遵循以下結構化流程:

- 在三個關鍵時段測試:早9點(中國工作起始時段)、下午2點(日本午休低峰)、晚8點(晚間流量尖峰)。

- 從至少五個地理節點發起測試:北京、上海、廣州、東京及美國西海岸節點(如舊金山)。

- 模擬應用負載場景:透過

wget --timeout=10測量靜態HTML載入時間,透過curl -w "Time: %{time_total}s" -o /dev/null https://api.server.com/data測量動態API回應時間,同時測試即時應用的WebSocket延遲。

多層級優化策略

有效的延遲降低需從伺服器、網路、使用者端三個層面解決問題,以下是各層面的技術優化方案:

伺服器層面的低延遲配置

首先從硬體與作業系統配置入手,針對執行Linux系統的Intel或AMD伺服器:

- CPU排程優化:透過

chrt -p 99 $(pidof application)為對延遲敏感的程序設定即時優先權,減少內容切換開銷。 - TCP參數調校:在

/etc/sysctl.conf中優化核心參數,降低連線建立延遲:net.ipv4.tcp_syncookies = 1 net.ipv4.tcp_tw_reuse = 1 net.ipv4.tcp_tw_recycle = 1 net.ipv4.tcp_fin_timeout = 30 net.core.default_qdisc = fq - 記憶體管理優化:啟用大頁(Huge Pages)減少頁表快取(TLB)遺失,執行

echo 1024 > /sys/kernel/mm/hugepages/hugepages-2048kB/nr_hugepages設定。 - 應用層優化:採用HTTP/2實現連線多工,啟用TLS 1.3加速交握過程;在高吞吐量場景下,利用NVIDIA GPU加速伺服器快取靜態資源。

網路基礎設施優化

網路延遲常源於路由不合理或頻寬受限,可透過以下方案解決:

- 選用高品質網路線路:優先選擇CN2 GIA(中國聯通全球網際網路接入)線路,這類專線壅塞率低。以北京方向為例,一般線路延遲約120ms,而CN2 GIA可降至80ms以下。

- BGP多線接入:為伺服器配置支援BGP協議的多營運商(如NTT、KDDI、中國電信)接入,使自治系統能根據即時路由表動態選擇最優路徑。

- 邊緣運算部署:在東京、大阪、福岡部署快取節點,為區域使用者提供在地化服務;搭配Cloudflare或Vercel Edge Network等CDN,利用任播(Anycast)IP跳過備援路由節點。

- 服務品質(QoS)設定:透過區分服務(DiffServ)或多協議標籤交換(MPLS)為延遲敏感流量(如VoIP、遊戲資料包)設定優先權。在Linux系統中,可透過

tc qdisc add dev eth0 root handle 1: htb default 10設定分層令牌桶(HTB)佇列。

使用者端與終端使用者優化

即便伺服器端優化到位,使用者端設定仍可能影響感知延遲,建議使用者執行以下操作:

- 優先使用有線乙太網路而非Wi-Fi,無線信號處理通常會增加10-30ms延遲。

- 在瀏覽器中啟用DNS預解析:在HTML標頭添加

<link rel="dns-prefetch" href="https://server.com">,提前解析IP位址。 - 合理選擇VPN:優先使用WireGuard(低延遲)而非OpenVPN協議,避免選擇伺服器超售的免費VPN服務。

- 更新網路驅動程式與韌體,尤其是Intel或AMD網卡,確保中斷聚合(Interrupt Coalescing)與卸載(Offloading)功能設定最優。

實戰案例:延遲優化落地效果

以下兩個案例展示了系統化優化如何實現延遲顯著降低:

案例1:面向東南亞的低延遲遊戲伺服器

某手遊廠商使用東京伺服器託管服務,尖峰時段面向曼谷使用者的延遲達150ms,優化路徑如下:

- 將標準IPv4路由切換為支援BGP任播的網路,透過新加坡直連節點互聯。

- 採用基於UDP的QUIC協議傳輸遊戲資料,相較TCP將交握延遲降低50%。

- 將伺服器網卡升級為10Gbps Intel X550-T2,啟用接收端縮放(RSS)實現多核心處理。

優化結果:平均延遲降至65ms,封包遺失率從8%降至0.5%,遊戲內回應速度顯著提升。

案例2:金融資料饋送延遲優化

某避險基金依賴東京證券交易所即時資料,因TLS 1.2加密連線及路由不合理,延遲達200ms,優化方案包括:

- 遷移至TLS 1.3協議,並啟用0-RTT恢復功能處理重複連線。

- 部署伺服器與交易所之間的專用低延遲鏈路,利用NVIDIA智慧網卡(SmartNIC)卸載加密處理工作。

- 在AMD EPYC伺服器上透過記憶體快取優化資料庫查詢流程,降低伺服器端處理延遲。

優化結果:端到端延遲降至90ms,符合高頻交易應用的合規要求。

常見問題(FAQ)

基礎故障排查

- 問:日本伺服器面向中國地區的正常延遲範圍是多少?

- 答:北京、上海等主要城市通常為60-120ms,廣州等沿海地區透過直連海底光纜,延遲可低至40-80ms。

- 問:為何Ping測試顯示延遲低,但應用仍卡頓?

- 答:Ping測試基於小型未加密的ICMP請求包,而實際應用流量(帶標頭資訊的TCP/UDP包、加密資料)會因協議開銷或伺服器處理延遲,出現更高的實際延遲。

進階場景問題

- 問:如何應對臨時國際頻寬不足?

- 答:啟用備用營運商的故障轉移(Failover)連線,透過流量整形優先傳輸關鍵資料,或臨時將流量路由至附近有剩餘頻寬的邊緣節點。

- 問:多雲架構能否協助管理延遲?

- 答:可以。透過在日本多個資料中心部署備援伺服器,搭配全域負載均衡器,將流量即時導向延遲最低的節點。

掌握日本伺服器延遲優化,需結合精準的診斷、軟硬體調校及網路架構規劃。技術人員透過系統化解決伺服器、網路、用戶端各層面問題,可充分發揮低延遲環境的價值。無論是管理高頻交易平台、全球SaaS應用還是區域遊戲服務,本文所述原則均可為持續效能優化提供框架。建議透過持續監控追蹤網路狀態,靈活適配網路變化,並借助前衛工具應對延遲挑戰。